III - QU'EST-CE QU'UNE IMAGE NUMéRIQUE?

2- caractéristiques d'une IMAGE

2.1- Résolution spectrale

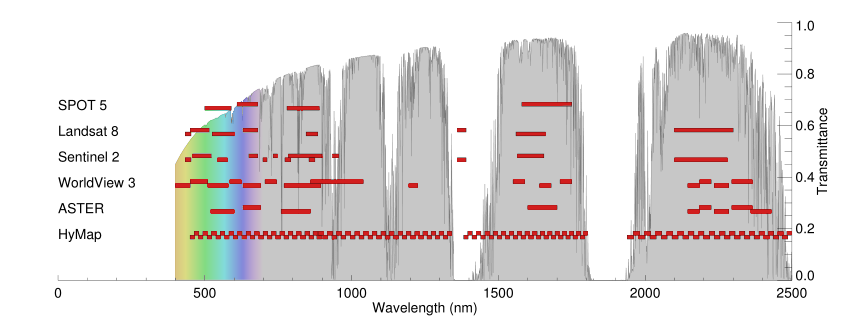

En fonction de leurs caractéristiques techniques, les capteurs embarqués à bord des satellites peuvent enregistrer le rayonnement réfléchi ou émis par les objets au sol dans différents intervalles de longueur d'onde donnés.

La résolution spectrale est l'aptitude du capteur à distinguer des rayonnements électromagnétiques de fréquences différentes. Plus le capteur est sensible à des différences spectrales fines (intervalles de longueur d'onde étroits), plus la résolution spectrale du capteur est élevée. La résolution spectrale dépend du dispositif de filtrage optique qui décompose l'énergie captée en bandes spectrales plus ou moins nombreuses et plus ou moins larges.

Une résolution spectrale élevée est par exemple nécessaire si on veut distinguer des types de cultures dont les signatures spectrales sont assez proches les unes des autres.

Largeurs de bande spectrale des capteurs SPOT-5, Landsat-8, Sentinel-2 , Worldview 3, ASTER en HyMAP. La transmission atmosphérique est représentée sur l'axe des ordonnées. Source: Potential of ESA's Sentinel-2 for geological applications - Scientific Figure on ResearchGate.

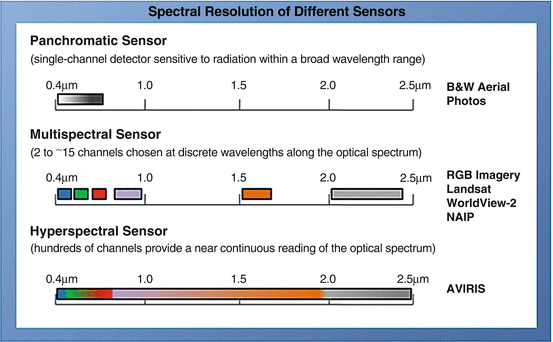

En télédétection optique, on distingue généralement trois grands types d’imagerie en fonction de leur résolution spectrale: l’imagerie panchromatique, multispectrale et hyperspectrale.

Source: Vegetation Analysis: Using Vegetation Indices in ENVI - ©2023 NV5 Geospatial Solutions, Inc.

Imagerie panchromatique

En télédétection, on utilise également des images en noir et blanc. Ce sont des images obtenues à partir de l'enregistrement dans un unique intervalle de longueur d'onde situé dans le domaine du visible, càd entre 0,4 et 0,7 µm. Elles ne fournissent des informations que sur l'intensité du rayonnement dans cet intervalle de longueur d'onde, sans faire de distinction entre les fréquences (et donc les couleurs). Comme les données ne sont acquises que dans un seul canal, chaque pixel ne se voit donc attribuer qu'une seule valeur. Si l'image est codée sur 8 bits, elle sera visualisable en 256 (28) niveaux de gris.

Ces images sont appelées images panchromatiques (littéralement : "toutes les couleurs"). L'avantage est qu'en raison de la gamme spectrale plus large, une plus grande quantité d'énergie atteint les cellules photoélectriques, ce qui permet de réduire le champ de vision (IFOV - voir Résolution spatiale) et d’obtenir davantage de détails spatiaux. En d'autres termes, de faibles variations de luminosité peuvent être détectés car chaque pixel capte une partie importante du rayonnement solaire.

Les images panchromatiques et multispectrales sont souvent fusionnées à l'aide d'une technique appelée "pansharpening" pour augmenter la résolution spatiale des images multispectrales.

Un exemple de ce type de fusion d'image est donné ci-dessous:

|

|

|

|

Image Landsat-8 de Bruxelles acquise le 28 mai 2020. Image en couleurs vraies en haut à gauche et image panchromatique en haut à droite. Les trois images en-dessous montrent un détail du parc de Bruxelles et du parc du Cinquantenaire : image panchromatique (à gauche), image en couleurs réelles (au milieu) et image fusionnée ou 'pan-sharpened' (à droite). Les données multispectrales utilisées pour créer le composite en couleurs vraies ont une résolution spatiale de 30 m par pixel. L'image panchromatique a une résolution spatiale de 10 m par pixel et semble donc beaucoup plus nette sur les extraits. La technique de pan-sharpening permet de relier les informations spectrales des images multispectrales aux pixels de l'image panchromatique spatialement plus détaillée.

Un autre exemple est illustré par la galerie d'images Pléiades ci-dessous, où se succèdent

- une image multispectrale de Bruxelles avec une résolution de 2 m;

- un extrait de cette image multispectrale centré sur la basilique de Koekelberg;

- un extrait centré sur la basilique de Koekelberg de l'image panchromatique avec une résolution de 50 cm;

- une image fusionnée ("pansharpened") de la basilique de Koekelberg avec une résolution de 50 cm.

L'animation ci-dessous montre l'effet du processus de pansharpening:

Imagerie multispectrale

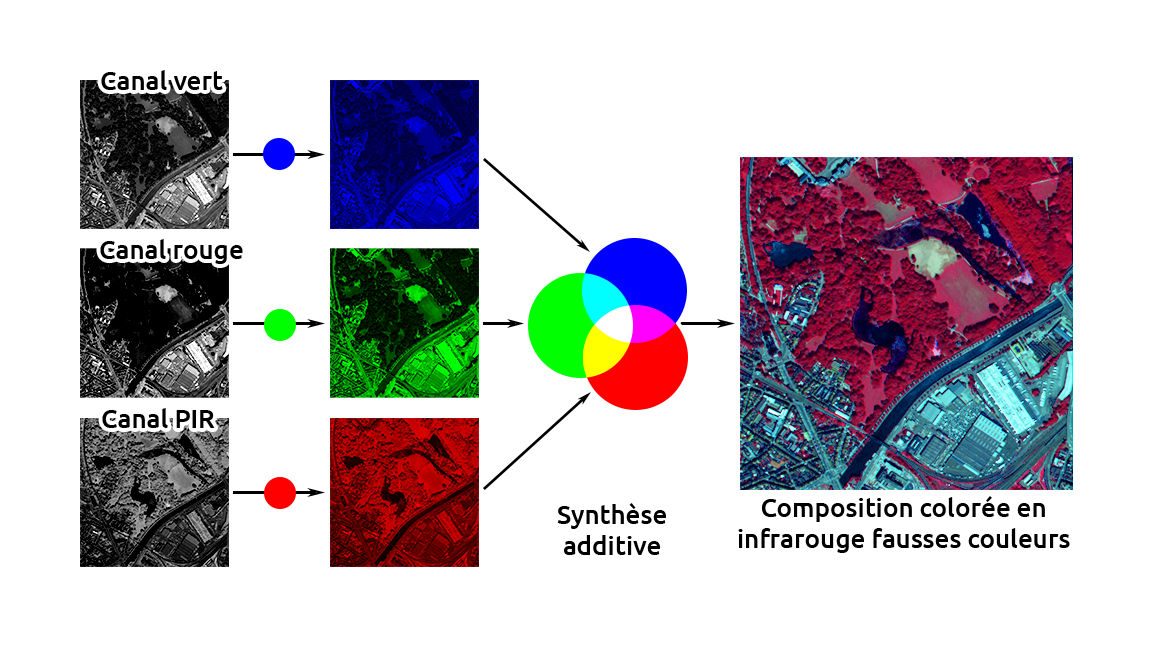

Les données multispectrales sont obtenues par des enregistrements simultanés dans un nombre relativement faible de bandes spectrales (3 à 15), généralement discontinues. Chaque bande couvre des intervalles de longueurs d'onde différents allant du visible à l'infrarouge. Les enregistrements dans ces différentes bandes spectrales peuvent être combinés pour obtenir des images en couleurs.

Les données de chaque bande sont représentées par l'une des couleurs primaires et, selon la luminosité relative (c.-à-d. la valeur numérique) de chaque pixel dans chaque bande, cette couleur est représentée par une valeur de gris spécifique (teinte). En combinant les pixels des trois bandes dans les trois couleurs primaires (rouge, vert, bleu) - chacune dans sa teinte en fonction de la valeur numérique de la bande respective - on obtient une image en couleur.

les bandes utilisées, les couleurs affichées peuvent ou non correspondre aux couleurs réelles; ainsi, des composites fausses couleurs peuvent aussi être créés (voir le chapitre 4 sur les fausses couleurs).

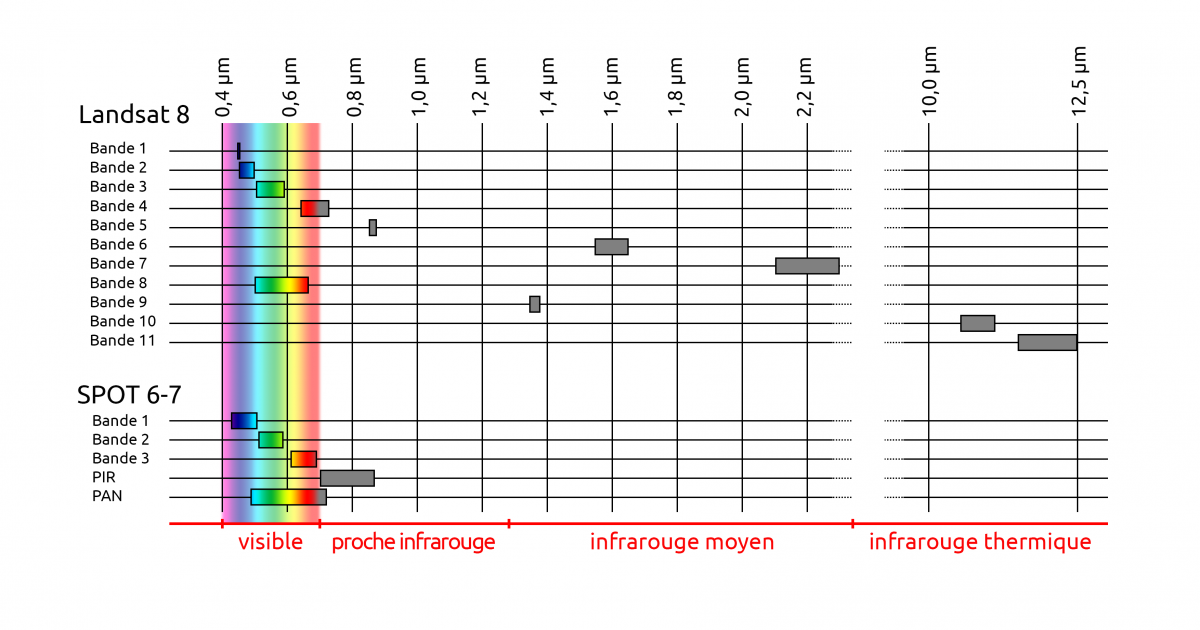

A titre d'exemple, le capteur OLI (Operational Land Imager) embarqué à bord des satellites LANDSAT 8 et 9 enregistre dans 8 bandes spectrales situées entre 0,43 et 2,29 µm en mode multispectral (4 dans le visible, 1 dans le proche infrarouge, 3 dans le moyen infrarouge) et dans une bande en mode panchromatique (bande 8), tandis que le capteur TIRS (Thermal Infrared Sensor) enregistre dans 2 bandes situées dans l'infrarouge thermique.

Le capteur NAOMI des satellites SPOT 6 et 7 comporte 4 bandes spectrales en mode multispectral:

- la bande bleue (1) couvre la partie du spectre allant de 0,450 à 0,520 µm

- la bande verte (2) de 0,53 à 0,59 µm

- la bande rouge (3) de 0,625 à 0,695 µm

- la bande proche infrarouge (PIR) de 0,76 à 0,89 µm

et une seule bande spectrale en mode panchromatique (PAN: 0,45 - 0,745µm ).

Imagerie hyperspectrale

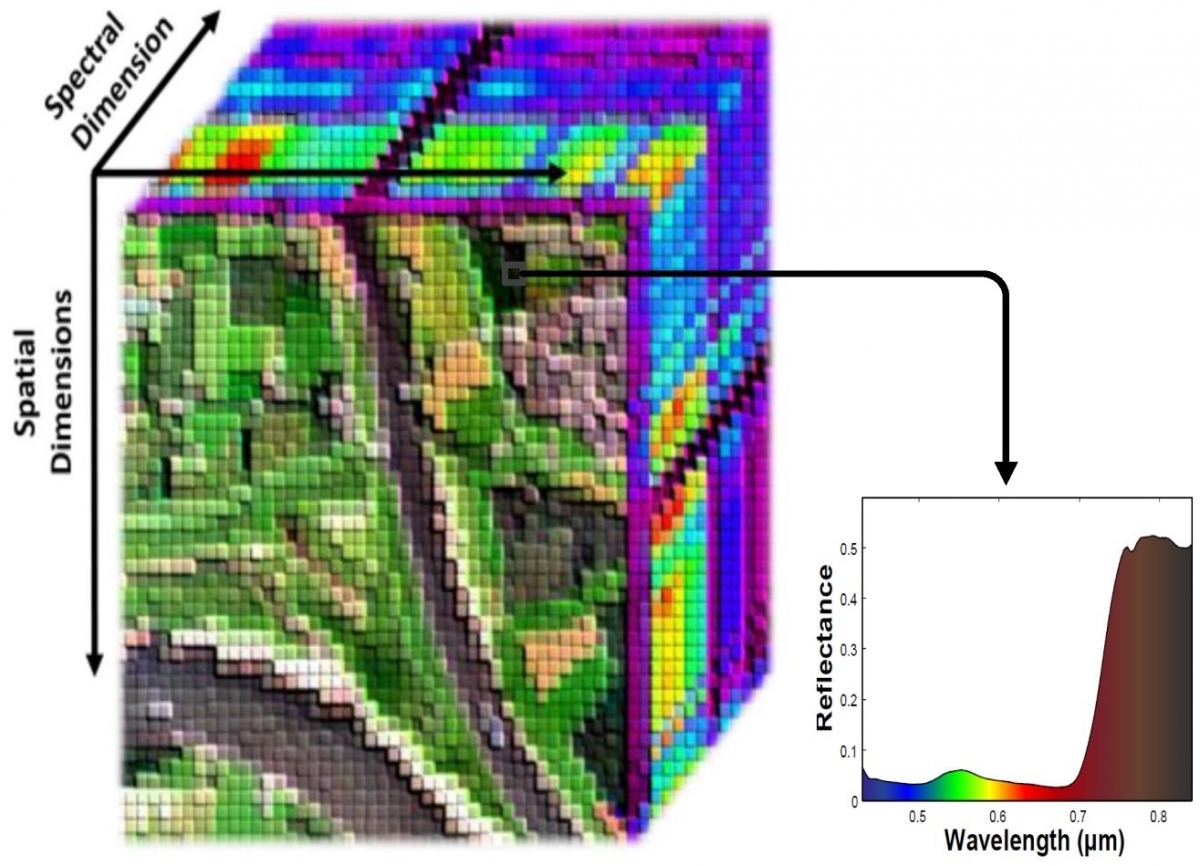

Les images hyperspectrales sont produites par des capteurs capables d'enregistrer l'information dans une multitude (souvent plus de 200) de bandes spectrales beaucoup plus étroites (de l'ordre de quelques nm) et souvent contiguës, dans les portions visible, proche infrarouge et proche infrarouge du spectre électromagnétique.

Les données hyperspectrales fournissent donc des informations plus détaillées sur les propriétés spectrales d'une scène. La signature spectrale des objets est plus fine et il est donc possible de distinguer et d’identifier les objets de manière plus précise (par exemple différentes roches, différents types de couverture végétale, différentes qualités ou compositions de l'eau, …) qu’avec les capteurs à larges bandes.

Chaque pixel d'une image hyperspectrale contient les informations recueillies dans une multitude de fenêtres d'acquisition réparties sur la totalité du spectre visible et infrarouge. La quantité d'informations à stocker et à traiter est donc énorme et nécessite une puissance de calcul bien plus importante que dans le cas des images multispectrales, ce qui peut constituer une réelle entrave, notamment pour le traitement de données portant sur de grandes surfaces.

Source: Rasti B. et al. (2018). Noise Reduction in Hyperspectral Imagery: Overview and Application. Remote Sensing. 10. 482.

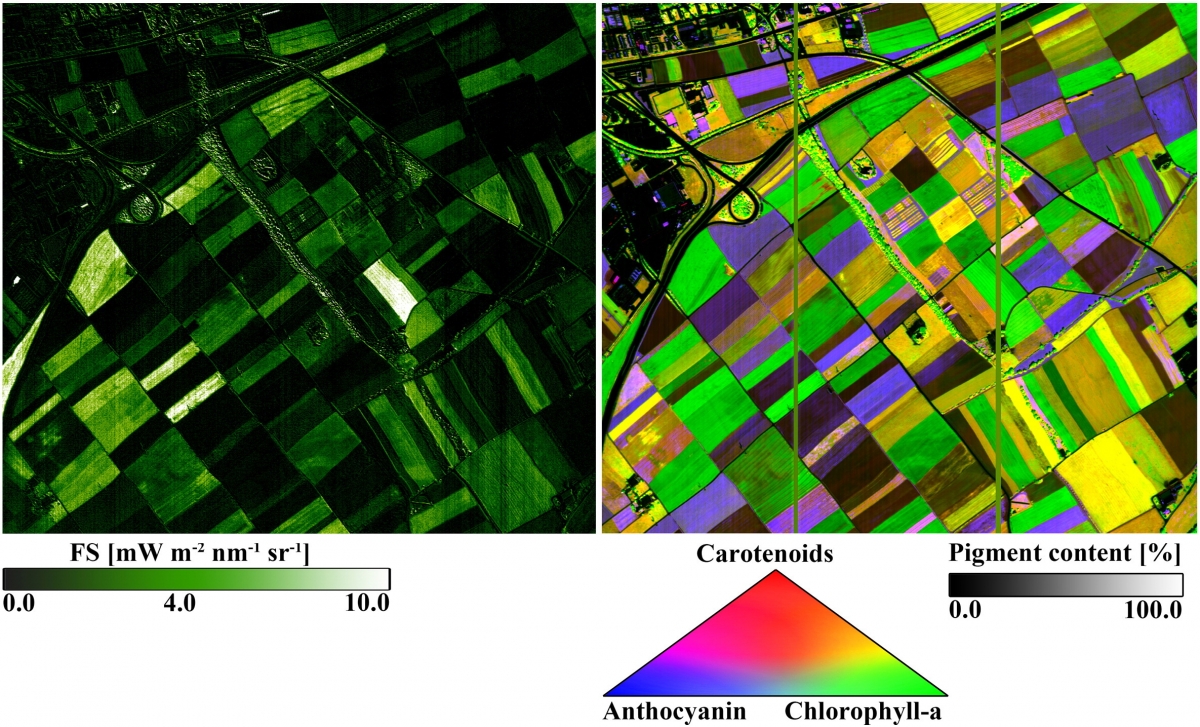

Les applications de l'imagerie hyperspectrale sont bien entendu multiples. Parmi les plus importantes, on peut citer la géologie (identification des minéraux…), l'agriculture de précision, la sylviculture (état sanitaire des ressources forestières, identification d'espèces…) ou la gestion des milieux aquatiques (qualité des eaux, composition du phytoplancton…)

|

Le spectro-radiomètre aéroporté APEX (Airborn Prism Experiment) est un spectromètre imageur développé pour l'ESA comme instrument de calibration et de validation d'un futur imageur hyperspectral satellitaire. APEX dispose d'un séparateur de faisceau qui divise le rayonnement en lumière visible et infrarouge (VNIR : 380 - 970nm) d'une part, et infrarouge à ondes courtes (SWIR : 940 - 2500nm) d'autre part. Le capteur possède un nombre sélectionnable de bandes spectrales allant jusqu'à 334 dans le VNIR (nominalement 114) et 198 dans le SWIR avec une résolution spectrale de respectivement 0,6 - 6,3 nm et 7,0 - 13,5 nm. Source: eoPortal

|

Résolution spectrale et images RADAR

Les images radar sont souvent considérées comme monochromatiques. En réalité, ce n’est pas tout à fait exact. Si, pour augmenter la résolution spatiale dans la direction de déplacement du capteur, on reconstitue étape par étape une antenne linéaire de très grande taille, dans l’autre dimension, on augmente la résolution spatiale en utilisant un signal codé pour pouvoir mesurer le temps de parcours du signal avec une très grande précision.

Ce codage se fait en fréquence. Dès lors, le signal utilisé n’est pas purement monochromatique mais possède une bande passante relativement étroite autour d’une fréquence porteuse.

Les radars les plus récents utilisent une bande spectrale de plus en plus large pour augmenter la résolution spatiale en distance.